TranslateGemma

2026年1月15日,谷歌发布基于 Gemma 3 架构的 TranslateGemma 开放翻译模型系列,共有 4B、12B 和 27B 三种参数规模,支持 55 种核心语言及多模态图像翻译,目前已在 Kaggle 和 Hugging Face 开放下载。并能处理图像翻译,旨在让开发者更容易地在各种设备上实现高质量的离线翻译。

关键特点:

- 基于 Gemma 3:深度优化了 Gemma 3 模型,并学习了 Gemini 的翻译知识。

- 多尺寸版本:

- 4B (40亿参数):适合手机等设备,支持离线运行。

- 12B (120亿参数):可在笔记本电脑上本地运行,性能优异。

- 27B (270亿参数):云端或高性能工作站用,追求最高精度。

- 高效的翻译性能:即使是 12B 模型,在 WMT24++ 评测中也超越了更大的基准模型,实现更小模型,更高质量,更快速。

- 多领域覆盖:在文学、新闻、社交、语音等多个领域的翻译上表现出色。

- 图像翻译:能直接翻译照片中的文字(如路标、菜单)。

- 开放访问:可在 Kaggle、Hugging Face 下载,或通过 Vertex AI 部署。

总之,TranslateGemma 旨在将强大的、大型模型(如 Gemini)的翻译能力浓缩并开放,让开发者能在更小的模型中获得媲美甚至超越大型模型的翻译质量,实现更广泛的部署应用。

Ollama TranslateGemma

Ollama 是一个本地运行大型语言模型(LLM)的工具,支持多种模型的下载和管理。通过 Ollama,用户可以在本地计算机上运行各种 LLM 模型,而无需依赖云服务(当然,Ollama现在也推出了自己的云模型:Cloud models · Ollama )。

Ollama 很快就集成了 Google 的 TranslateGemma 模型,用户可以通过 Ollama 在本地运行 TranslateGemma,实现高质量的离线翻译。

只要安装了 Ollama,就可以直接下载并运行 TranslateGemma 模型:

|

|

默认会下载 translategemma:latest 版本(4B的版本,3.3GB大小,亲测翻译质量很好,速度很快),可以通过指定标签来选择不同的模型大小:

|

|

字幕工具箱集成 TranslateGemma

字幕工具箱是一个功能强大的字幕处理工具,支持字幕翻译、时间轴调整、格式转换等多种功能。最近,字幕工具箱集成了 Ollama 的 TranslateGemma 模型,用户可以直接在字幕工具箱中使用本地运行的 TranslateGemma 进行高质量的字幕翻译。

要使用本地的 Ollama 服务进行字幕翻译,只需在字幕工具箱的翻译设置中选择“本地 Ollama”,选择对应的模型,如 translategemma:4b 或 translategemma:12b,然后输入要翻译的文本,字幕工具箱会调用本地的 TranslateGemma 模型进行翻译,生成高质量的字幕翻译结果。

实现该功能有三个注意事项:

- 需要先安装并运行 Ollama 服务,确保本地可以访问 Ollama 模型。

- 在字幕工具箱中正确配置 Ollama 的地址和端口,默认是

http://localhost:11434。字幕工具箱或别的网页应用只能把前端发送到 Ollama 的本地服务地址。你不能把发送请求的操作写在服务端代码里,因为 Ollama 的服务是运行在你本地的机器上的,服务器是无法访问你本地的服务的。 - 本地的ollama 服务需要开启跨域请求支持(CORS),可以通过 Ollama 的设置选项和配置环境变量启用。

前端代码示例:

前面也说了,请求 Ollama 的操作必须在前端代码中完成。

ollama 本地api的地址默认为 http://localhost:11434/api/chat。

以下为 curl 示例:

|

|

javascript 示例:

|

|

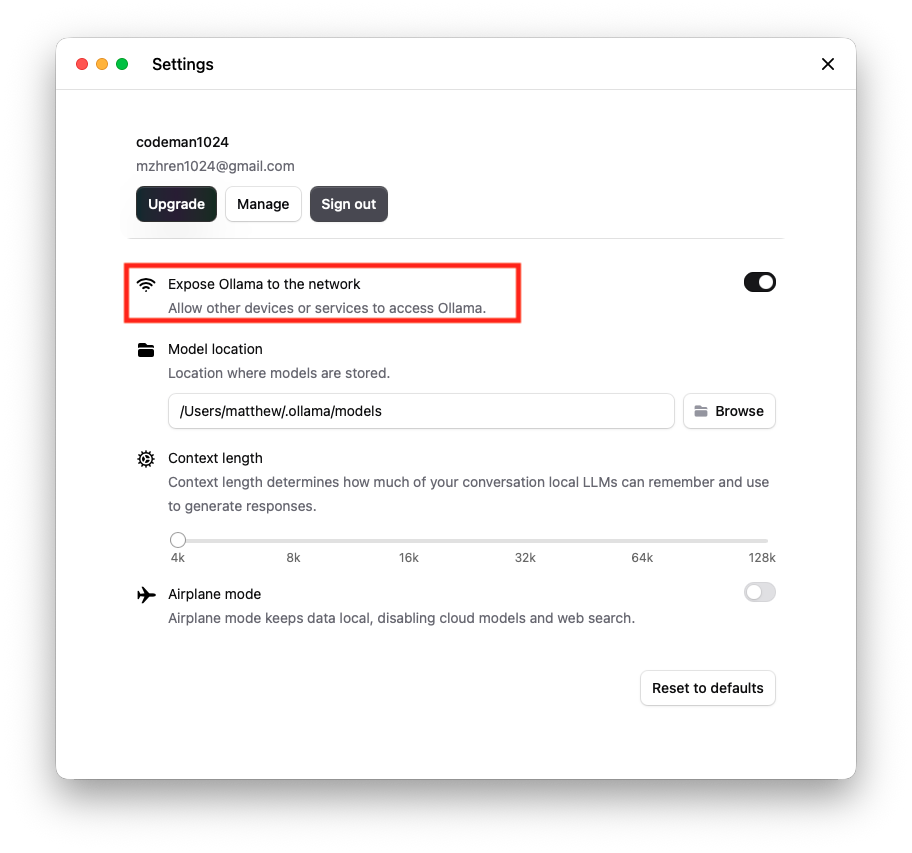

ollama 跨域请求支持(CORS)

- 开启

Expose Ollama to the network选项:

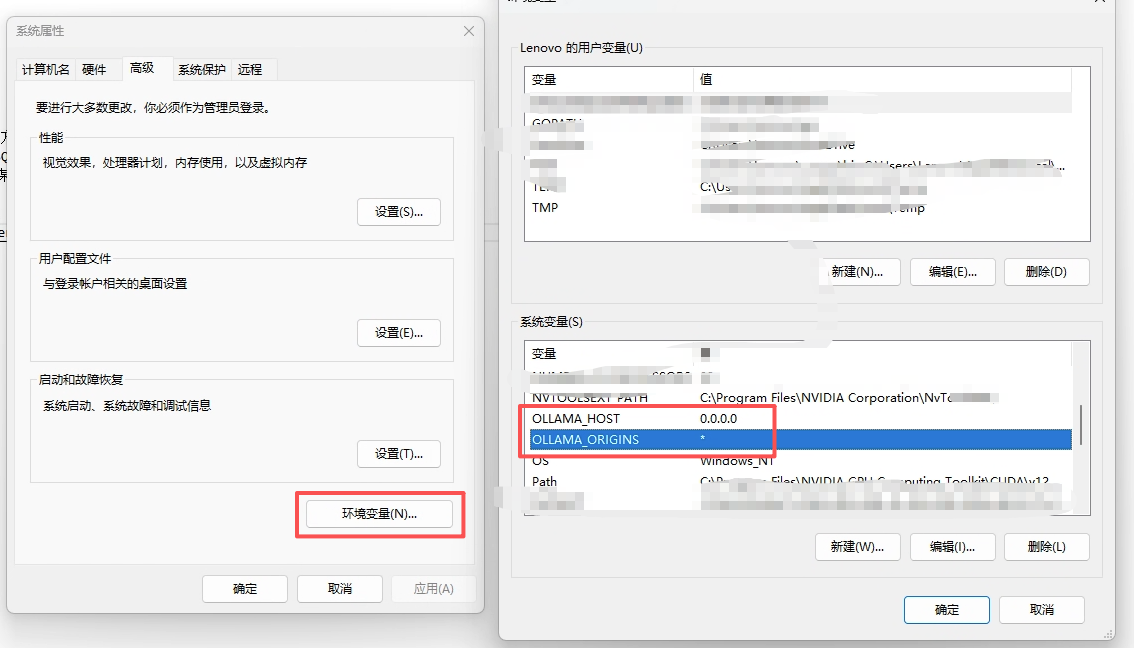

- 设置跨域请求环境变量:

由于 Ollama 的默认参数配置,启动时设置了仅本地访问,所以跨域访问以及端口监听需要进行额外的环境变量设置 OLLAMA_ORIGINS。

在在 macos 或 Linux 系统中,使用 launchctl 设置环境变量:

|

|

也可以指定具体的域名:

|

|

在 Windows 系统中,可以通过环境变量设置窗口进行设置:

配置完成后,重启 Ollama 服务即可。